-

Steam 版暗黑 4 换区

暗黑破坏神 4 必须连接暴雪的战网服务器才能启动。 国内的 Steam 版暗黑 4 玩家,就需要手动换区。有两…

-

Steam Deck 修改默认密码

Steam Deck 默认用户名为 deck 没有密码,正常安装运行游戏也不需要密码。 但是如果你需要在桌面模…

-

为原生 ESM 时代做好准备

你可能已经写了很多年 ES Module (ESM) 语法的代码。比如: 但实际上,大部分 ESM 语法代码是…

-

暗黑 4 掉帧解决方法

由于暴雪的游戏引擎设计缺陷,导致 GPU 满载的情况下会持续显存泄漏,帧率逐步下降到个位数,直至完全不可玩。最…

-

React 19 为何令人失望

2023 年 12 月,React 19.0.0 终于发布。但是经过一些实验之后,我决定暂缓升级我的 Reac…

-

Linux 科学上网:Hosts

被墙的不严重的网站,通常是被 DNS 污染了。这种网站用 Hosts 方法就很容易实现科学上网。Hosts 即…

-

暗黑4死灵法师配方

威能 项链:统御秘术(项链) 统御秘术威能附在装备上可以增加 2 个骷髅战士和 2 个骷髅法师。而附加在项链可…

-

原生 Linux 游戏的现状

虽然大部分 Windows 游戏可以通过 Wine/Proton 在 Linux 上运行,但是运行效率损耗导致…

-

欧洲旅行攻略

来自小欢欢的旅行计划~~~ 申根签证 包含国家 已经刷过的: 还没刷过的: 准备材料 注意事项: 网上提交 欧…

-

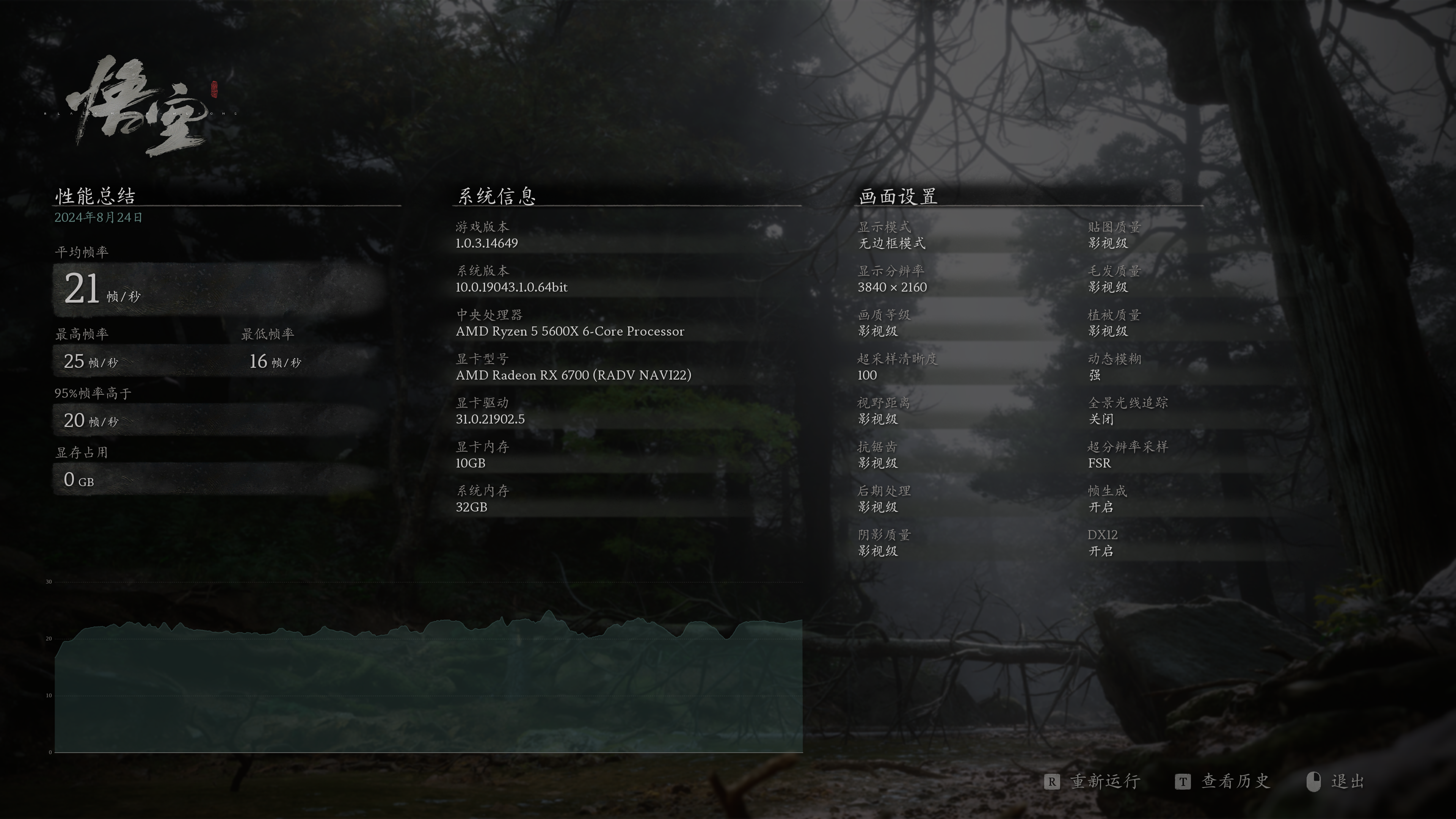

《黑神话:悟空》RX6700 Linux 性能测试

采用《黑神话:悟空性能测试工具》测试。 CPU:AMD Ryzen R5 5600X RAM:4*8GB DD…

-

为什么建议关掉垂直同步

垂直同步(V-Sync)是为了解决 GPU 输出帧率与显示器刷新率不一致而导致的画面撕裂问题而诞生的技术。它的…

-

Switch ROM 格式 XCI 和 NSP 的区别

NPS 和 XCI 最主要的区别在于来源的数据载体。 XCI 文件是从 Switch 实体卡带导出的。一些 S…